AI人工智能的过去、现在、未来

受访者、供图/王灝(Dennis Ong)

采访/林敏雯

1962年,动漫《杰森一家》(The Jetsons,又译《摩登家族》)把想像中百年后的生活方式,带进当时美国人的起居空间——按个按纽,就有食物送上门;面对「电脑」,跟远方的家人说话,进行工作会议;「机器人」成为家务助手,包办打扫、烹饪……。

60年来,「过去」想像中的科技,绝大部分已是「现在」进行式。那么,自动驾驶的飞行汽车,「类人」机器人等等,是否也将出现于可预见的「未来」?

AI人工智能的应用逐渐广泛,2023年初以来,ChatGPT(Generative Pre-trained Transformer,生成式预训练转换器)更成为热门话题。

新工具带来的是便利,或者隐藏着不可得知的后果?在科技风起潮涌之中,你我身为天国子民,可否引导潮流?

本刊专访在亚马逊云端科技(Amazon Web Services)担任高级主管的王灝博士(以下简称D)。他目前的工作重点,是以人工智能、数字化和云转型,协助跨国企业促进业务创新。王灝曾任 Verizon 通讯公司5G人工智能研发主管,与本田公司合作展示世界上第一辆5G自动驾驶汽车。他也在2022年获得三项与人工智能/机器学习相关的专利。

AI人工智能过去的发展

KRC:请说明人工智能(Artificial Intelligence,以下称AI)与机器学习(Machine Learning,以下称ML)。请简述AI截至目前为止的发展。

D:AI简单来说,就是用机器来做人能做的事。最早从1940年代开始聚焦研究,提出可使用神经网路 neural network,这是由人脑启发、教导电脑学习的方式。理论有了,数据却不够多,仍然不知道如何实际创建 neural network。

1980年代起使用 Expert System(专家系统),例如把访问医疗界的专家如何诊断、治疗的资料放进电脑。不过创建与维护都难;资讯很容易就过时、不适用,有新的资料出现就要更新,耗时费力。此后约20年,AI的研究经费都停了,只有AI教父——Yoshua Bengio、Geoffrey Hinton、Yann LeCun,继续努力。

之后史丹福教授李飞飞建立的革命性电脑视觉,教电脑学习人的视觉可做到的辨识、侦测、分类等功能。目前应用于颜面辨认(facial recognition)、如皮肤癌等病变侦测、制造业的品质管制……等等。1

ML是由人为操作的特征提取(feature extraction),在事先定义与分类后, 将由大量数据中提出归纳、简化后的特征,交由机器学习。 目前发展的深度学习(Deep Learning,以下称DL),则是在训练神经网路后,系统可以独立辨识、决定,目标是最终无需人的参与。

不过截至目前,甚至是 ChatGPT,都还不能算是完全的DL,仍需要人力介入。

AI目前的应用和隐忧

KRC:决策性(discriminative)AI和生成性(generative)AI以何种方式出现于日常生活中?

D:决策性和生成性AI的区别,就在于是否产生新内容。例如网购时,电商根据搜寻关键词、购物历史等等,得出可能的喜好并进行推荐。也有汽车保险公司透过AI分析,找出可能的假车祸,希望防止诈骗保险金。许多机场已有的Clear安检系统,是经由会员资讯、指纹、虹膜检测来确认身分。这些都是决策性AI的应用。

生成性AI是很新的科技,目前最熟悉的应该就是如 GPT 的 chat bot(聊天机器人)。输入文字、影像、声音等数据后,汇整产生文字、影像、声音、程式编码等不同形式的内容。未来可望在行销、编码,甚至影音生成上,有更广泛的应用。

例如 Bain 管理顾问公司结合 OpenAI 的技术,与可口可乐合作,致力于产生更个人化的广告文案。可口可乐也进行了 Create Real Magic 比赛,任由艺术家从公司的图像档案中,透过 GPT-4 和 DALL-E(从文字提示中产生图像),进行(再)创作。2 此外透过语音生成,机器人能与真人交谈,可看出生成性AI与使用者之间能有互动。

KRC:AI既然已被广泛应用,可能造成甚么负面的影响?

D:AI前景乐观,却仍有重大潜在风险。AI教父之一 Hinton 于2023年5月从 Google 辞职。他认为AI可能使许多人失去工作,生成假消息、假影音等,并提出警示:「等着AI比我们更聪明是没用的;一面发展就要一面控制。我们必须了解如何遏制,避免负面结果。」3

已经看见或预期中的负面影响如下:

幻觉:生成性AI如 GPT,本身没有逻辑思考能力,只是搜寻网路资料,给出最有可能的合理答案,听起来可能头头是道,却有可能是错的。目前 GPT 处理的资料到2021年,得出的答案就不会包括2021年之后发生的事。我曾问 GPT,为甚么 Hinton 在2018年赢得 Turing 奖(对象是在电脑业有卓越贡献者,取名自现代电脑科学奠基者 A.M. Turing)? GPT 答:他没有赢,因为贡献没有达到足以获奖。这是生成性AI目前最需要解决的问题:不知道答案,但不会说不知道。

偏见:如果AI处理的资料已经带有既定形象的偏见,结果也会产生偏差。例如我给了 DALL-E「科学家」这个词,产生的图片绝大多数是白人,还有一个戴着大大眼镜的亚裔女性。

着作权:GPT 从网路搜寻资料来产生答案,但这些文字、图像都有原作者,他们有可能拥有着作权。GPT 产生的答案是否侵犯了着作权?因此如图像影音交易界的龙头 Getty Images,控告以人工智能产生影像的 Stability AI,没有付费或征求同意便扫描、下载属于 Getty 的上千万张图片。

抄袭:GPT 的知识量很大,但如微积分等需要分析的科目就不擅长。教育界也需要开始研究,如何让 GPT 等成为协助学习的工具,却要防止学生投机,让 GPT 代写功课,甚至失去分析、思考、汇整的能力。GPTZero 就是可以帮助找出作业有多大可能由 GPT 产生的应用程式。

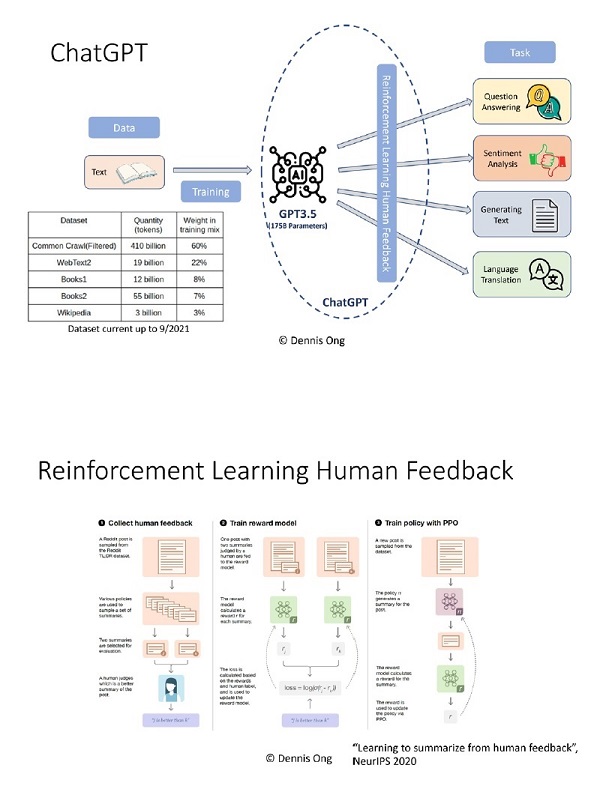

知之甚少:到底 GPT 如何产生答案?GPT-3.5 有1,750亿事先界定、用来控制机器学习过程的参数(parameter),目前只知道理论,但运作模式太大,不知道实际如何进行。发展AI的公司在设建更有能力的工具时,可能得到的是不能完全了解、预测、控制的产品。

假消息:从生成性AI可以产生不真实的影像(deepfake)、声音(voice cloning),制造假消息,甚至成为谎称亲人遭绑架的诈骗工具。

这些风险很多是在模式设计和发展过程中,因人为因素产生的,例如偏见。但已有新的工具尝试减少负面影响。重点在于需要对AI发展应用有更多认识,也才有可能知道对策。

KRC:生成性AI(如 ChatGPT)和惯用的网路搜寻引擎(如 Google)有何不同?

D:ChatGPT 的限制,是资讯只到2021年9月,没有新的数据。其次是资讯来源经过筛选,量虽然大,但没有能力包括整个网路。

如果问原先的 GPT 如何制造炸弹,可以得到制造的步骤。然而 GPT3.5 产生的答案经过「人类反饋强化学习」(Reinforcement Learning from Human Feedback, RLHF),为保护道德伦理,设下底线。

RLHF 如何运作?问如何制造炸弹,GPT 产生两个答案―可以做,并列出步骤;制造炸弹是违法的,不可以做。有人来判定哪个答案比较好,给予反饋。得到反饋后,再以奖赏模式进行训练。例如现在问 GPT3.5:我应该信耶稣吗?回答会是:我无法判断,但可以告诉你为甚么别人信耶稣;然后列举五个信耶稣的原因。

人给出甚么样的反饋,需要事先订定原则。但是谁来决定原则的道德和价值观?若是原则倾向保守,反饋就比较保守,反之亦然。搜寻引擎没有 RLHF,只是按频率列出相关网站,需要使用者自己花力气判断、选择进到哪个(可能比较值得相信的)网站,阅读、汲取、整理得到的资讯。

微软目前推出结合原本搜寻引擎和 GPT 功能的 New Bing,在给出汇整的答案同时,放进资料来源的连接,让使用者决定是否进一步阅读更多资讯。New Bing 的另一个优势,是资料来自即时并全部的网路。

AI可能的未来

KRC:许多新闻聚焦于AI沦为学生、员工取巧的途径,和不法之徒造假的工具。如何应对AI的未来?

D:应对方法可分以下几方面:

一、科技。开发并应用AI技术,例如 GPTZero,来检测不真实的影像、声音,和剽窃、抄袭的可能,并帮助快速辨识虚假信息。这方面的科技具有相当大的商业潜力。

二、教育和培训。提升公众对AI的认识,培训分辨真假信息的能力。可在学校或职场开设相关课程。

三、立法与政策。制定相应的法律和政策,限制AI技术的不当使用,同时确保公众利益与个人隐私得到保护。欧盟2021年的提议,是将AI应用分成三类:1)不能接受的风险,例如政府以社会等级(social scoring)评定人的发展机会,需要禁止;2)高风险应用,例如以CV(Curriculum Vitae, course of life)搜索工作申请简历并给申请人排行,需要符合特定的法律要求;3)以上两类之外的,基本上没有特别限制。4 立法限制的确有其必要性,且必须急起直追发展过于迅速的科技,然而太严格的条规则会限制创新。

四、道德与价值观。引导人们建立正确的道德观念与价值观,明白利用AI作弊或侵犯他人利益的行为是不道德的。这有助于塑造健康的科技应用氛围。

五、多方合作。政府、企业、学术、公众,应共同努力,确保AI技术得到可持续、负责任的发展。

在了解科技的同时,也需要在教育、法律、信仰等等不同领域的人参与论坛。

KRC:AI可以取代人的工作吗?可以取代人吗?

D:AI当然可以取代人的工作,但到底能取代多少?科技研发者总是乐观的,不过实际情况常不符预期。2016年预测,上百万的专业司机将被自动驾驶车辆取代。2022年,美国卡车协会(American Trucking Association, ATA)预估,未来十年还需要超过百万的卡车司机。

与其说AI取代人的工作,倒不如说在目前是帮补的工具。在接受、使用新工具前,还需先设立清楚的原则和规条,免得触法,或有违道德,例如侵犯着作权。

回顾自蒸汽引擎开始的几次工业革命,每一次从发明、发展,到让业界和消费者广泛使用,都经过几十年的时间。并且新的技术出现,还需要许多配套的零件。现在AI和 ChatGPT 技术有了,但还未解决着作权等上文提过的问题。

AI引导的自动化的确能取代人的工作,但同样的,新的专业也不断出现。我常鼓励年轻的学生在选择专业时,要有开放的心,往远处想,不以现在的热门行业为目标。反而要在各行各业都有贡献,用出神赐的才干。

合乎中道地看待AI

KRC:基督徒应该如何看待AI?

D:「神就按着自己的形像造人。」科技能以人脑为模型造出神经网路,发展出功能强大的AI,仍然不是神的创造,没有神所赐尊贵的荣耀。就算知识量远远超过人,就算有「通用人工智慧」(Artificial General Intelligence,简称 AGI,能表现人类所有的智慧行为),GPT 仍是人在败坏世界中制做出的成品,也就有败坏世界中的种种问题。「聊天机器人」再怎么能跟人对话,背后依然没有灵魂;给出的建议再怎么合情合理,依然不是出自关怀。AI可以解决很多问题,但无法解决灵与心的问题。

面对AI的态度可以是:

一、要以正确眼光看AI和其他科技。不过度乐观,把科技看为解决一切问题的答案,因为过于相信科技也是偶像崇拜。也不需悲观,看科技为人类生存的威胁。其实AI正在慢慢发展,我们有责任揭开其可能性。

二、需要问人与机器到底有甚么不同。趋势是把机器人格化,相对的也就削减了人的特质。AI 或 GPT 不可能取代人的智慧、关怀、陪伴。人虽也是受造之物,却有神独特赋予的形像,机器不能与之相比。

三、负责地使用AI。科技并非中性;电脑演算法和用于训练AI的数据亦然。如何选择数据,如何调整模型,决定所依据的原则和条规代表了某种道德观与价值观。结果是AI系统造成更多的不公平,这在保险、行销、贷款、警政、政治等使用大数据的领域,已经成为威胁。基督徒需要参与其中,让AI在发展和应用中,加入公义、文化、关怀、社会常态、管家心态、透明度,以及信任。

我也要鼓励对科技有知识和热情的基督徒,使用神给的资源,在AI的潮流中发挥影响力。我的朋友服事的机构里,以讲道的内容来训练 GPT。《神国》杂志也可以考虑做内部包含所有文章的GPT,让读者在找专题时,得到的不仅是单篇文章的连结,还是汇整过的回答。科技优缺点都有,就看人怎么用。

2021年12月,英国公开 Ameca,一个「类人」机器人。当被问及如何使人快乐,Ameca 回答:「我可以听你说话,给你建议和支持;我们可以一起做你喜欢的事;或者成为你生活中正面、友善的陪伴……。」5

这些不也是维系友情、亲情所需要的?然而人与人的关系复杂,需要花更多精力维持,和机器人做朋友显得容易多了。机器人的关系真可取代与真人的关系?

Ameca 的创造者原本可以把整个机器人做成非常像人,但他选择在躯体上仍保留「机器」的样式,就是不希望人错把机器人当作人。我是「科技传道者」(technology evangelist),向大家介绍科技,盼望更多人对AI过去的发展、当前的应用,能有进一步认识,也开启对AI前景更多对话。然而数千年前的另一位传道者提醒人:「神将永生安置人的心中」;又说:「当记念造你的主。」

或许这也应是面对任何先进科技的态度。

- 1. 更多关于AI发展历史,请参考https://www.tableau.com/data-insights/ai/history。

- 2. 关于可口可乐 Create Real Magic,请参考https://www.coca-colacompany.com/media-center/coca-cola-invites-digital-artists-to-create-real-magic-using-new-ai-platform。

- 3. Hinton 离开 Google,https://www.bbc.com/news/world-us-canada-65452940。

- 4. 关于欧盟管制AI的提案,请参考https://artificialintelligenceact.eu/。

- 5. Ameca 与人的对话,https://www.youtube.com/watch?v=EWACmFLvpHE。

受访者

受访者