AI人工智能的過去、現在、未來

受訪者、供圖/王灝(Dennis Ong)

採訪/林敏雯

1962年,動漫《傑森一家》(The Jetsons,又譯《摩登家族》)把想像中百年後的生活方式,帶進當時美國人的起居空間——按個按紐,就有食物送上門;面對「電腦」,跟遠方的家人說話,進行工作會議;「機器人」成為家務助手,包辦打掃、烹飪……。

60年來,「過去」想像中的科技,絕大部分已是「現在」進行式。那麼,自動駕駛的飛行汽車,「類人」機器人等等,是否也將出現於可預見的「未來」?

AI人工智能的應用逐漸廣泛,2023年初以來,ChatGPT(Generative Pre-trained Transformer,生成式預訓練轉換器)更成為熱門話題。

新工具帶來的是便利,或者隱藏著不可得知的後果?在科技風起潮湧之中,你我身為天國子民,可否引導潮流?

本刊專訪在亞馬遜雲端科技(Amazon Web Services)擔任高級主管的王灝博士(以下簡稱D)。他目前的工作重點,是以人工智能、數字化和雲轉型,協助跨國企業促進業務創新。王灝曾任 Verizon 通訊公司5G人工智能研發主管,與本田公司合作展示世界上第一輛5G自動駕駛汽車。他也在2022年獲得三項與人工智能/機器學習相關的專利。

AI人工智能過去的發展

KRC:請說明人工智能(Artificial Intelligence,以下稱AI)與機器學習(Machine Learning,以下稱ML)。請簡述AI截至目前為止的發展。

D:AI簡單來說,就是用機器來做人能做的事。最早從1940年代開始聚焦研究,提出可使用神經網路 neural network,這是由人腦啟發、教導電腦學習的方式。理論有了,數據卻不夠多,仍然不知道如何實際創建 neural network。

1980年代起使用 Expert System(專家系統),例如把訪問醫療界的專家如何診斷、治療的資料放進電腦。不過創建與維護都難;資訊很容易就過時、不適用,有新的資料出現就要更新,耗時費力。此後約20年,AI的研究經費都停了,只有AI教父——Yoshua Bengio、Geoffrey Hinton、Yann LeCun,繼續努力。

之後史丹福教授李飛飛建立的革命性電腦視覺,教電腦學習人的視覺可做到的辨識、偵測、分類等功能。目前應用於顏面辨認(facial recognition)、如皮膚癌等病變偵測、製造業的品質管制……等等。1

ML是由人為操作的特徵提取(feature extraction),在事先定義與分類後, 將由大量數據中提出歸納、簡化後的特徵,交由機器學習。 目前發展的深度學習(Deep Learning,以下稱DL),則是在訓練神經網路後,系統可以獨立辨識、決定,目標是最終無需人的參與。

不過截至目前,甚至是 ChatGPT,都還不能算是完全的DL,仍需要人力介入。

AI目前的應用和隱憂

KRC:決策性(discriminative)AI和生成性(generative)AI以何種方式出現於日常生活中?

D:決策性和生成性AI的區別,就在於是否產生新內容。例如網購時,電商根據搜尋關鍵詞、購物歷史等等,得出可能的喜好並進行推薦。也有汽車保險公司透過AI分析,找出可能的假車禍,希望防止詐騙保險金。許多機場已有的Clear安檢系統,是經由會員資訊、指紋、虹膜檢測來確認身分。這些都是決策性AI的應用。

生成性AI是很新的科技,目前最熟悉的應該就是如 GPT 的 chat bot(聊天機器人)。輸入文字、影像、聲音等數據後,彙整產生文字、影像、聲音、程式編碼等不同形式的內容。未來可望在行銷、編碼,甚至影音生成上,有更廣泛的應用。

例如 Bain 管理顧問公司結合 OpenAI 的技術,與可口可樂合作,致力於產生更個人化的廣告文案。可口可樂也進行了 Create Real Magic 比賽,任由藝術家從公司的圖像檔案中,透過 GPT-4 和 DALL-E(從文字提示中產生圖像),進行(再)創作。2 此外透過語音生成,機器人能與真人交談,可看出生成性AI與使用者之間能有互動。

KRC:AI既然已被廣泛應用,可能造成甚麼負面的影響?

D:AI前景樂觀,卻仍有重大潛在風險。AI教父之一 Hinton 於2023年5月從 Google 辭職。他認為AI可能使許多人失去工作,生成假消息、假影音等,並提出警示:「等著AI比我們更聰明是沒用的;一面發展就要一面控制。我們必須了解如何遏制,避免負面結果。」3

已經看見或預期中的負面影響如下:

幻覺:生成AI如 GPT,本身沒有邏輯思考能力,只是搜尋網路資料,給出最有可能的合理答案,聽起來可能頭頭是道,卻有可能是錯的。目前 GPT 處理的資料到2021年,得出的答案就不會包括2021年之後發生的事。我曾問GPT,為甚麼 Hinton 在2018年贏得 Turing 獎(對象是在電腦業有卓越貢獻者,取名自現代電腦科學奠基者 A.M. Turing)? GPT 答:他沒有贏,因為貢獻沒有達到足以獲獎。這是生成性AI目前最需要解決的問題:不知道答案,但不會說不知道。

偏見:如果AI處理的資料已經帶有既定形象的偏見,結果也會產生偏差。例如我給了DALL-E「科學家」這個詞,產生的圖片絕大多數是白人,還有一個戴著大大眼鏡的亞裔女性。

著作權:GPT 從網路搜尋資料來產生答案,但這些文字、圖像都有原作者,他們有可能擁有著作權。GPT 產生的答案是否侵犯了著作權?因此如圖像影音交易界的龍頭 Getty Images,控告以人工智能產生影像的 Stability AI,沒有付費或徵求同意便掃描、下載屬於 Getty 的上千萬張圖片。

抄襲:GPT 的知識量很大,但如微積分等需要分析的科目就不擅長。教育界也需要開始研究,如何讓 GPT 等成為協助學習的工具,卻要防止學生投機,讓 GPT 代寫功課,甚至失去分析、思考、彙整的能力。GPTZero 就是可以幫助找出作業有多大可能由 GPT 產生的應用程式。

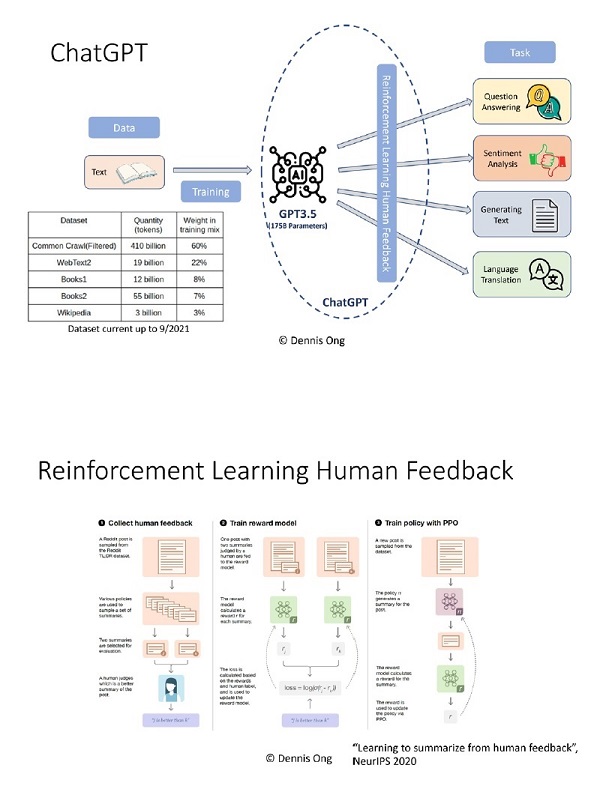

知之甚少:到底 GPT 如何產生答案?GPT-3.5 有1,750億事先界定、用來控制機器學習過程的參數(parameter),目前只知道理論,但運作模式太大,不知道實際如何進行。發展AI的公司在設建更有能力的工具時,可能得到的是不能完全了解、預測、控制的產品。

假消息:從生成性AI可以產生不真實的影像(deepfake)、聲音(voice cloning),製造假消息,甚至成為謊稱親人遭綁架的詐騙工具。

這些風險很多是在模式設計和發展過程中,因人為因素產生的,例如偏見。但已有新的工具嘗試減少負面影響。重點在於需要對AI發展應用有更多認識,也才有可能知道對策。

KRC:生成性AI(如 ChatGPT)和慣用的網路搜尋引擎(如 Google)有何不同?

D:ChatGPT 的限制,是資訊只到2021年9月,沒有新的數據。其次是資訊來源經過篩選,量雖然大,但沒有能力包括整個網路。

如果問原先的 GPT 如何製造炸彈,可以得到製造的步驟。然而 GPT3.5 產生的答案經過「人類反饋強化學習」(Reinforcement Learning from Human Feedback, RLHF),為保護道德倫理,設下底線。

RLHF 如何運作?問如何製造炸彈,GPT 產生兩個答案―可以做,並列出步驟;製造炸彈是違法的,不可以做。有人來判定哪個答案比較好,給予反饋。得到反饋後,再以獎賞模式進行訓練。例如現在問 GPT3.5:我應該信耶穌嗎?回答會是:我無法判斷,但可以告訴你為甚麼別人信耶穌;然後列舉五個信耶穌的原因。

人給出甚麼樣的反饋,需要事先訂定原則。但是誰來決定原則的道德和價值觀?若是原則傾向保守,反饋就比較保守,反之亦然。搜尋引擎沒有 RLHF,只是按頻率列出相關網站,需要使用者自己花力氣判斷、選擇進到哪個(可能比較值得相信的)網站,閱讀、汲取、整理得到的資訊。

微軟目前推出結合原本搜尋引擎和 GPT 功能的 New Bing,在給出彙整的答案同時,放進資料來源的連接,讓使用者決定是否進一步閱讀更多資訊。New Bing 的另一個優勢,是資料來自即時並全部的網路。

AI可能的未來

KRC:許多新聞聚焦於AI淪為學生、員工取巧的途徑,和不法之徒造假的工具。如何應對AI的未來?

D:應對方法可分以下幾方面:

一、科技。開發並應用AI技術,例如 GPTZero,來檢測不真實的影像、聲音,和剽竊、抄襲的可能,並幫助快速辨識虛假信息。這方面的科技具有相當大的商業潛力。

二、教育和培訓。提升公眾對AI的認識,培訓分辨真假信息的能力。可在學校或職場開設相關課程。

三、立法與政策。制定相應的法律和政策,限制AI技術的不當使用,同時確保公眾利益與個人隱私得到保護。歐盟2021年的提議,是將AI應用分成三類:1)不能接受的風險,例如政府以社會等級(social scoring)評定人的發展機會,需要禁止;2)高風險應用,例如以CV(Curriculum Vitae, course of life)搜索工作申請簡歷並給申請人排行,需要符合特定的法律要求;3)以上兩類之外的,基本上沒有特別限制。4 立法限制的確有其必要性,且必須急起直追發展過於迅速的科技,然而太嚴格的條規則會限制創新。

四、道德與價值觀。引導人們建立正確的道德觀念與價值觀,明白利用AI作弊或侵犯他人利益的行為是不道德的。這有助於塑造健康的科技應用氛圍。

五、多方合作。政府、企業、學術、公眾,應共同努力,確保AI技術得到可持續、負責任的發展。

在了解科技的同時,也需要在教育、法律、信仰等等不同領域的人參與論壇。

KRC:AI可以取代人的工作嗎?可以取代人嗎?

D:AI當然可以取代人的工作,但到底能取代多少?科技研發者總是樂觀的,不過實際情況常不符預期。2016年預測,上百萬的專業司機將被自動駕駛車輛取代。2022年,美國卡車協會(American Trucking Association, ATA)預估,未來十年還需要超過百萬的卡車司機。

與其說AI取代人的工作,倒不如說在目前是幫補的工具。在接受、使用新工具前,還需先設立清楚的原則和規條,免得觸法,或有違道德,例如侵犯著作權。

回顧自蒸汽引擎開始的幾次工業革命,每一次從發明、發展,到讓業界和消費者廣泛使用,都經過幾十年的時間。並且新的技術出現,還需要許多配套的零件。現在AI和 ChatGPT 技術有了,但還未解決著作權等上文提過的問題。

AI引導的自動化的確能取代人的工作,但同樣的,新的專業也不斷出現。我常鼓勵年輕的學生在選擇專業時,要有開放的心,往遠處想,不以現在的熱門行業為目標。反而要在各行各業都有貢獻,用出神賜的才幹。

合乎中道地看待AI

KRC:基督徒應該如何看待AI?

D:「神就按著自己的形像造人。」科技能以人腦為模型造出神經網路,發展出功能強大的AI,仍然不是神的創造,沒有神所賜尊貴的榮耀。就算知識量遠遠超過人,就算有「通用人工智慧」(Artificial General Intelligence,簡稱 AGI,能表現人類所有的智慧行為),GPT 仍是人在敗壞世界中製做出的成品,也就有敗壞世界中的種種問題。「聊天機器人」再怎麼能跟人對話,背後依然沒有靈魂;給出的建議再怎麼合情合理,依然不是出自關懷。AI可以解決很多問題,但無法解決靈與心的問題。

面對AI的態度可以是:

一、要以正確眼光看AI和其他科技。不過度樂觀,把科技看為解決一切問題的答案,因為過於相信科技也是偶像崇拜。也不需悲觀,看科技為人類生存的威脅。其實AI正在慢慢發展,我們有責任揭開其可能性。

二、需要問人與機器到底有甚麼不同。趨勢是把機器人格化,相對的也就削減了人的特質。AI 或 GPT 不可能取代人的智慧、關懷、陪伴。人雖也是受造之物,卻有神獨特賦予的形像,機器不能與之相比。

三、負責地使用AI。科技並非中性;電腦演算法和用於訓練AI的數據亦然。如何選擇數據,如何調整模型,決定所依據的原則和條規代表了某種道德觀與價值觀。結果是AI系統造成更多的不公平,這在保險、行銷、貸款、警政、政治等使用大數據的領域,已經成為威脅。基督徒需要參與其中,讓AI在發展和應用中,加入公義、文化、關懷、社會常態、管家心態、透明度,以及信任。

我也要鼓勵對科技有知識和熱情的基督徒,使用神給的資源,在AI的潮流中發揮影響力。我的朋友服事的機構裡,以講道的內容來訓練 GPT。《神國》雜誌也可以考慮做內部包含所有文章的GPT,讓讀者在找專題時,得到的不僅是單篇文章的連結,還是彙整過的回答。科技優缺點都有,就看人怎麼用。

2021年12月,英國公開 Ameca,一個「類人」機器人。當被問及如何使人快樂,Ameca 回答:「我可以聽你說話,給你建議和支持;我們可以一起做你喜歡的事;或者成為你生活中正面、友善的陪伴……。」5

這些不也是維繫友情、親情所需要的?然而人與人的關係複雜,需要花更多精力維持,和機器人做朋友顯得容易多了。機器人的關係真可取代與真人的關係?

Ameca 的創造者原本可以把整個機器人做成非常像人,但他選擇在軀體上仍保留「機器」的樣式,就是不希望人錯把機器人當作人。我是「科技傳道者」(technology evangelist),向大家介紹科技,盼望更多人對AI過去的發展、當前的應用,能有進一步認識,也開啟對AI前景更多對話。然而數千年前的另一位傳道者提醒人:「神將永生安置人的心中」;又說:「當記念造你的主。」

或許這也應是面對任何先進科技的態度。

- 1. 更多關於AI發展歷史,請參考https://www.tableau.com/data-insights/ai/history。

- 2. 關於可口可樂 Create Real Magic,請參考https://www.coca-colacompany.com/media-center/coca-cola-invites-digital-artists-to-create-real-magic-using-new-ai-platform。

- 3. Hinton 離開 Google,https://www.bbc.com/news/world-us-canada-65452940。

- 4. 關於歐盟管制AI的提案,請參考https://artificialintelligenceact.eu/。

- 5. Ameca 與人的對話,https://www.youtube.com/watch?v=EWACmFLvpHE。

受訪者

受訪者